Jetson AGX Orinは最高のLLM推論PCになり得るか?

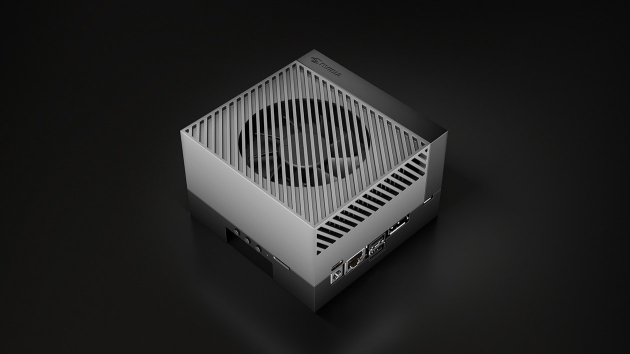

Jetsonという、Nvidiaが直接開発する小型コンピューターのシリーズがあります。

「エッジAIデバイス」と呼ばれ、基本的にはロボットやAI関連の研究開発・サービスに用いられる組み込みコンピューターという位置付けの製品群です。

あくまで通常のPCとは異なる特定用途の計算機ですから、ローカルLLMという文脈の中では殆ど登場することのない彼らですが・・・

実はこれ、LLM推論に最高に相性のいいPCなんじゃないか?

ふと思ったので調査してみました。

結論:

・Jetsonは26.5万円で70BサイズのLLMを推論できる高コスパデバイス

・しかし多くの問題もある

・人によっては使い道があるが、基本的におすすめはできない

そもそもJetsonというのは、簡単に言えば「高性能GPU付きのシングルボードコンピューター」です。

いうなれば小さくて高性能なLinux PC。

「機械学習アプリを目的とした組み込みエッジコンピューティングデバイス」といえば仰々しいですが、特別なことはそんなに無いのです。そんなには。

Youtubeも見れるし、ゲームも(一応)出来るし、そしてプログラミングにも使えるよという。

それら目的に買うには少し高価格ですが、そこはAI処理特化ゆえです。

Jetson AGX OrinのLLM性能を見る

細かいスペックの項目を調べる前に、結果として達成されたLLM性能の一例を見てみます。

Nvidiaの公式ブログによれば、このデバイスはLlama 2 70Bという大型のLLMを単独で推論することができ、更にそのt/s(トークン数毎秒)は4.4ということです。(参照: https://developer.nvidia.com/blog/bringing-generative-ai-to-life-with-jetson/)

この時点ですごい。

なにしろ、RTX4090を搭載するような最上級のゲーミングPCですら不可能なことです。

単体GPUとしてこの規模のモデルを動かすにはRTX A6000のようなサーバー向けGPUがスタートラインですが・・・こちらに至ってはGPUだけで60万円程度。

半分以下、26.5万円のJetsonがそれを少なくとも実行できてしまうというのは特別な価値です。

また推論速度についてもそう酷くはありません。

公式の仕様書では4.4t/s・・・今の水準ではめちゃくちゃ遅いものの、初期のGPT-4を思えば許容できる範囲です。ちょうど英語で発音会話をするのと同じ程度の速度。

ただこれは明らかに理論値、スペックから計算できる最高限の速度に思えます。後述しますが・・・実際に全てのケースで同様に扱えるかは不明です。

とはいっても、ここまではすごく良く見えます。

なにしろLlama 3 70Bモデルを現実的な速度で自宅推論しようと思ったら、普通のPCを買う視点では「PCの基本部品+大容量のマルチGPU」という正攻法か、あるいは50万円〜のMacを買うということになるはず。

対してJetson AGX Orinでは26万円一台で全てが完結です。

そう考えるとめちゃくちゃコスパの良い選択肢ですよね。

・・・が、実をいうと逆に弱点もすごく多いのです。

ローカルLLMの観点では問題とならない弱点もありますが、そうでないものもいくつか。

次以降の項でデバイスの仕様を見て、具体的なメリットとデメリットを比較していきましょう。

性能仕様

デバイスのLLM推論性能を見るにあたって重要な情報は、まず何よりもVRAM(GPUメモリ)の容量。次いでVRAMの帯域幅、そしてわずかにGPUそのものの計算性能です。その他、消費電力や価格も。

で、Jetson AGX Orinですが・・・特殊な点が一つ。

ユニファイドメモリを採用しています。

つまり、普通のPCではGPUメモリとCPUメモリ(メインメモリ)を別に扱い「VRAMが16GBでメインメモリが32GB」というようにするわけですが、このデバイスに関しては「CPUとGPUで合わせて64GB」となっているんです。

なので純粋なVRAM容量を測るということはできないのですが・・・まあLLM推論に限った話をするということで、ここではCPU占有は常に0として計算します。

そんなわけで、以下が仕様表です。

メモリ(VRAM): 64GB

帯域幅: 204GB/s

TOPS: 275

消費電力: 15W~65W

価格26.5万円~35万円

ストレージ: 64GB Emmc 5.1

アーキテクチャ: ARM64

OS: Jetson OS(Linux for Tegra)

それぞれ見ていきます。

64GBのメモリ

LLM推論にはメモリ容量が欠かせません。

LLMに最初の一文字でも生成をさせるためには、基本的にそのモデル自体よりも大きな容量を持つGPUがあるべきです。あるいは複数のGPUを用意すればメモリを合算させて扱う事も可能です。

参考として主要な大型モデルの必要メモリは、

llama-3.1-70bのq4・・・40GB

mistral-large-2407のq4・・・59GB

という感じ。

で、Jetson AGX Orinのメモリは64GB。上記のモデルを一台だけで実行させることが可能です。

それがこのデバイスの最大の強み。普通この価格帯では絶対に得られない大きさなんです。

他のGPUの例を挙げると、

・RTX A6000・・・48GB, 約70万円

・RTX 4090・・・24GB, 約30万円

・RTX 3090・・・24GB, 約16万円

・RTX3060・・・12GB, 約4万円

というところ。もちろんこれだけではなく、GPUを乗せるPCにも金がかかります。

・・・え?RTX3060を5、6個そろえた方が安い?

それに関しては後程。

204GB/sのメモリ帯域幅

メモリ容量は実行できるモデルそのものに関わりますが、帯域幅はその速度に直接影響します。

で、Jetson AGX Orinのメモリ帯域幅は204GB/s。40GBサイズのモデルを扱う場合、理論上の最大値としても一秒間に5トークン程度の生成が限界であるということになります。

先ほど見た公式発表が4.4トークン/秒ということだったので、ある程度納得できますね。

ただ、この帯域幅はGPUと比べるとかなり遅い部類に入ります。

先ほど挙げたGPUでは、

・RTX A6000・・・768GB/s

・RTX 4090・・・1008GB/s

・RTX 3090・・・936GB/s

・RTX 3060・・・360GB/s

と見事に惨敗。

基本的にGPUは帯域幅に比べて容量が少ない状況が多いと思うんですが、AGX Orinに関しては真逆ですね。

しかし、低いといえど204GB/s。一般的な最高レベルのメインメモリの二倍程度はあります。

普通のGPUに比べては大きく劣るけど、CPUよりは大きく勝るという絶妙なラインです。

275のTOPS

TOPSはTera-operations-per-secondの略称で、「一秒間に何テラ回の計算が可能か」という指標です。int8。

これはGPUの計算性能そのものを直接示してくれる良い指標です。

例によって他GPUと比べると、

・RTX A6000・・・619

・RTX 4090・・・1321

・RTX 3090・・・568

・RTX 3060・・・191

と・・・一見、殆どに大きく負けているんですが、ここは実際さほど気にしなくて大丈夫です。

というのは、LLM推論の場合にはどれも十分すぎるほど高いから。

メモリ帯域幅がボトルネックとなるので、どうしたってオーバーパワーなんです。

60Wの消費電力(TDP)

地味にすごい数値です。

LLMの推論をするPCといったら普通は大型家電並みの消費電力のはずで、

・RTX A6000・・・300

・RTX 4090・・・450

・RTX 3090・・・350

・RTX 3060・・・170

とGPUだけでも文字通り桁が違います。(しかもPC本体の消費電力は別にかかってくる)

対してJetson AGX Orinは全部込みで15~60Wですから、ちょうどエアコンと扇風機くらいの差。

先ほどの性能比でみても圧倒的に高コスパであることが分かります。

ただ問題は・・・趣味目的程度であれば、LLMの推論をしている時間なんて一日のうちわずかでしょう。実際に電気代を問題視するかはかなり微妙なところです。必要ならGPUに電力制限をかけることもできますし。

業務用などで常時回しておく必要があるならうれしいかも。

26.5~35万円の価格

価格の幅は購入側の所属によって決まります。学生、教育関係者、研究者は26.5万円。それ以外は35万円。

これがかなり難しいラインです。26.5万円として、メモリあたりの価格は0.4万円。

もう一度他GPUを見返すと、

・RTX A6000・・・48GB, 約70万円, 1GBあたり1.45万円

・RTX 4090・・・24GB, 約30万円, 1GBあたり1.25万円

・RTX 3090・・・24GB, 約16万円, 1GBあたり0.7万円

・RTX3060・・・12GB, 約4万円, 1GBあたり0.3万円

ということで、Jetsonもかなり安い部類であることには違いがありません。しかも全部入りですから。

ただ、メモリ帯域幅の低さを見ると・・・もう少し予算を増やして、例えば圧倒的に高性能なRTX3090を二台買うとか、RTX3060を6枚そろえるとか(かなり無理があるけど)の構築の方が結果的に良い気もしてきます。

とりわけ、もともと巨大なデスクトップPCを持っているなら追加の費用もかかりませんし。(無い場合は安く見積もって+10万円)

64GBのeMMCストレージ

よく考えるとこれはひどいです。iPhone 4s(2011年発売)と同じ容量。実質VRAMとストレージが同サイズって。

これじゃあ使い物にならない・・・んですが、ただこのデバイスはSSDのNVMe接続がサポートされているので、その気になれば最新レベルのストレージを付け足せます。

というか、基本価格に+1万円を見込んでSSD追加を前提としておいた方がいいかもしれません。

専用OSのJetsonOS

さて、ここからが良くも悪くもJetsonの本領発揮です。

このデバイスはPCの一種ではあるものの、WindowsやMacといった一般的なOSは搭載できません。

JetsonOSというUbuntuベースの専用OSが用意されているんです。

なのであなたがWindowsやMacユーザーである場合、根本的な操作そのものに不自由を感じる可能性があります。

とはいえ、LLM推論を本格的に進めていくなら結局はUbuntuのようなLinux OSを扱うことになるでしょう。そう考えるとそこまで問題ではない気もします。

しかしUbuntuにすら慣れていない状態でこの独自OSに触れるのは、殆どの人にはちょっとした挑戦になるかもしれません。

ARM64アーキテクチャ

もう一つ言及しなければならないのがこれ。

アーキテクチャ・・・これは簡単に言えば、PCとしての根本的な設計そのものの話です。普通のほとんどの(家電量販店や大学生協で売られているような)PCはx86-64アーキテクチャというもので設計されています。

Jetsonはそうではなく、主にスマホやゲーム機で用いられる方のARM64アーキテクチャを採用。

これが何を意味するかというと、普通のPC用に作られたソフトなどの多くが使えないということになってしまうんです。

まあLLM推論に関しては現状は特別問題でないと思いますが、しかし他の一般的なソフトなどを使う時には大きな懸念点です。

先日発表されたSnapdragon Xなど、ARM64を採用したPCも流行りつつあるようですが・・・今はまだ、簡単におすすめ出来るものではないかも。

強みと弱み

さて、そんなわけで大体の評価はまとまりました。c

強み:

メモリの巨大さ

低い消費電力

超小型

弱み:

メモリ帯域幅の低さ

Ubuntuベースの独自OS

ARM64アーキテクチャ

これを踏まえて、他のありえそうなPC構築例との比較をしたうえで結論を出そうと思います。

比較元: Jetson AGX Orin

予算: 26.5万円(35万円)

メモリ: 64GB

帯域幅: 204GB/s

TOPS: 275

TDP: 60W

vs. RTX 3090 x2 デスクトップPC

予算: 45万円

メモリ: 48GB

帯域幅: 936GB/s

TOPS: 568

TDP: 約900W

評価: 現時点で最推奨の構築との比較。ただし割引視点で見て倍近くの価格差です。メモリは48GBと少ないですが、帯域幅(≒生成速度)なら四倍以上と天と地の差です。大型モデルを高速に扱いたい場合は絶対にこちら。

とはいえ消費電力は1/15なので、待てる時間さえあれば最終的にはコスパでJetsonの勝ちです。

vs. RTX 3060 x5 マイニングリグ

予算: 28万円

メモリ: 60GB

帯域幅: 360GB/s

TOPS: 191

TDP: 約1000W

評価: 理論上最も高コスパな構築との比較。RTX3060を5枚も挟めるデスクトップPCは存在しないので必然的にマイニングリグか、野ざらしにライザーケーブルを使うことになります。

理論上はほぼ同額で同等のメモリを得、更に帯域幅は倍近くです。

理論上は。実際にはこれ、尋常じゃない構築です。

取り巻く数多くの問題については専用ページで取り扱います: (未投稿)

vs. 中古P40 x2 デスクトップPC

予算: 15万円

メモリ: 48GB

帯域幅: 347GB/s

TOPS: 47

TDP: 700W

評価: 旧式サーバー用GPUであるP40の中古を使う方法です。BIOSの設定やCUDAの対応、ビデオ出力の問題など数多くの問題を解決できるのならばコスパ最高ですが・・・ここではスルー。いろいろと知識が必要な構築です。

vs. M2 Max Mac Studio

予算: 35万円

メモリ: 64GB

帯域幅: 400GB/s

TOPS: 15.8

TDP: 約145W

評価: 実はMacはLLM推論にめちゃくちゃ向いてます。メモリはAGX Orinと互角、帯域幅の高さは倍、そして価格は少し上です。ただ20倍近いTOPSの差は・・・LLM推論ですら差があるだろうし、他の用途も考えると本当に「ローカルLLM推論マシン」として扱う覚悟が必要です。CUDAを使えないのも非常につらい。

結論

あんま良くない、微妙かも・・・

確かに26.5万円で70Bサイズのモデルを動かせる、超小型、省電力、数多くのメリットはあります。

しかし予算を増やせばもっとずっと良いものが手に入るということ、その気になれば価格面でもより良い選択肢があることなど、冷静になってみるとこれを選ぶケースってかなり稀な気がします。

小型モデルを常時推論する業務目的での使用や、すさまじく長い時間をかけて学習を行う場合、あと持ち運んでカフェで使う必要がある場合などには良いかもしれません。

Comments